杨净 发自 凹非寺

量子位 | 公众号 QbitAI

“这太疯狂了!”

“18个月前,训练NeRF需要5小时…”

“2个月前,训练NeRF需要是5分钟!”

“现在,训练NeRF需要5秒!!??”

究竟发生了什么?竟让谷歌研究科学家惊叹至此。

(插播一下此前风靡的NeRF模型:伯克利&谷歌联合打造,少数静态图生成3D逼真效果)

而且类似的评价还有很多~

介绍这项技术的博文也热度非常,不到一天时间就收获了上千赞。

原来,这是来自于英伟达的最新技术——基于多分辨率哈希编码的即时神经图形基元。

一只狐狸NeRF模型的只需要训练5秒钟!

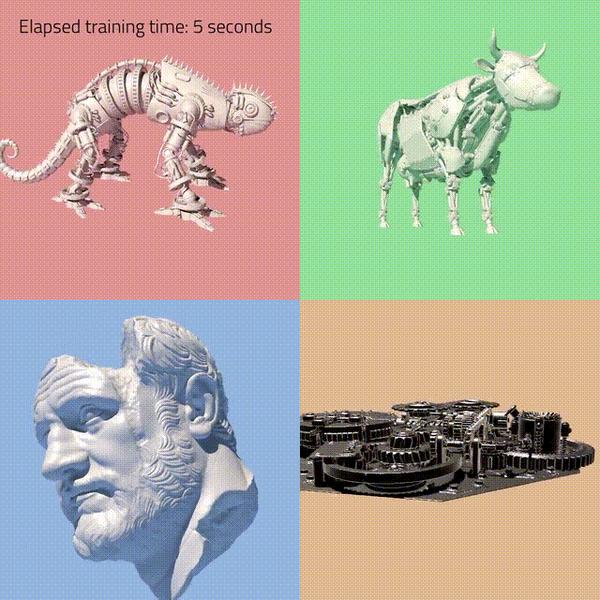

而且不光训练NeRF,该技术还在其他任务上也达到了惊人的训练速度。

实现了几个数量级的组合加速。

能够在几秒钟内训练高质量的神经图形基元,并在几十毫秒内渲染分辨率1920x1080的图形。

单个GPU上实现多任务即时训练

先来看效果。

有没有种在实验室的眩晕感,这是来自iPhone视频训练5分钟的360度实时渲染效果~

还有想以34张真实照片重构的3D图像~

除了NeRF之外吗,还有三个神经图形基元的实现。

Gigapixel Image

作者还友情提示,网络是从头开始训练的,如果眨眼的话,可能会错过它。

Signed Distance Function

Neural Radiance Cache

每种情况都是用tiny-cuda-nn框架训练和渲染的,本次实验是在RTX 3090测试的。

以全连接网络为参数的神经图形基元,训练和评估成本较高。

本文使用了一种多功能的新输入编码来降低成本。

这种编码允许在不牺牲质量的情况下使用更小的网络,从而大大减少浮点数和内存访问数量。

具体而言,一个小型神经网络通过可训练特征向量的多分辨率哈希表进行扩充。这些特征向量的值通过随机梯度下降优化。

换句话说,这种编码与任务无关。

研究团队表示,他们在所有任务中都使用相同的案例和超参数,只改变了哈希表的大小。

目前该项目已开源,感兴趣的旁友可戳下方链接~

GitHub链接:

https://github.com/NVlabs/instant-ngp

论文链接:

https://nvlabs.github.io/instant-ngp/assets/mueller2022instant.pdf

项目链接:

https://nvlabs.github.io/instant-ngp/

参考链接:

https://twitter.com/ak92501/status/1481818982005063681

—完—

@量子位 · 追踪AI技术和产品新动态

深有感触的朋友,欢迎赞同、关注、分享三连վ'ᴗ' ի ❤

本文转自 知乎,原文链接:https://zhuanlan.zhihu.com/p/457696087,如需转载请自行联系原作者